پیشنهادهای عجیب هوش مصنوعی گوگل به کاربران: به پیتزای خود چسب اضافه کنید و سنگ بخورید! + عکس

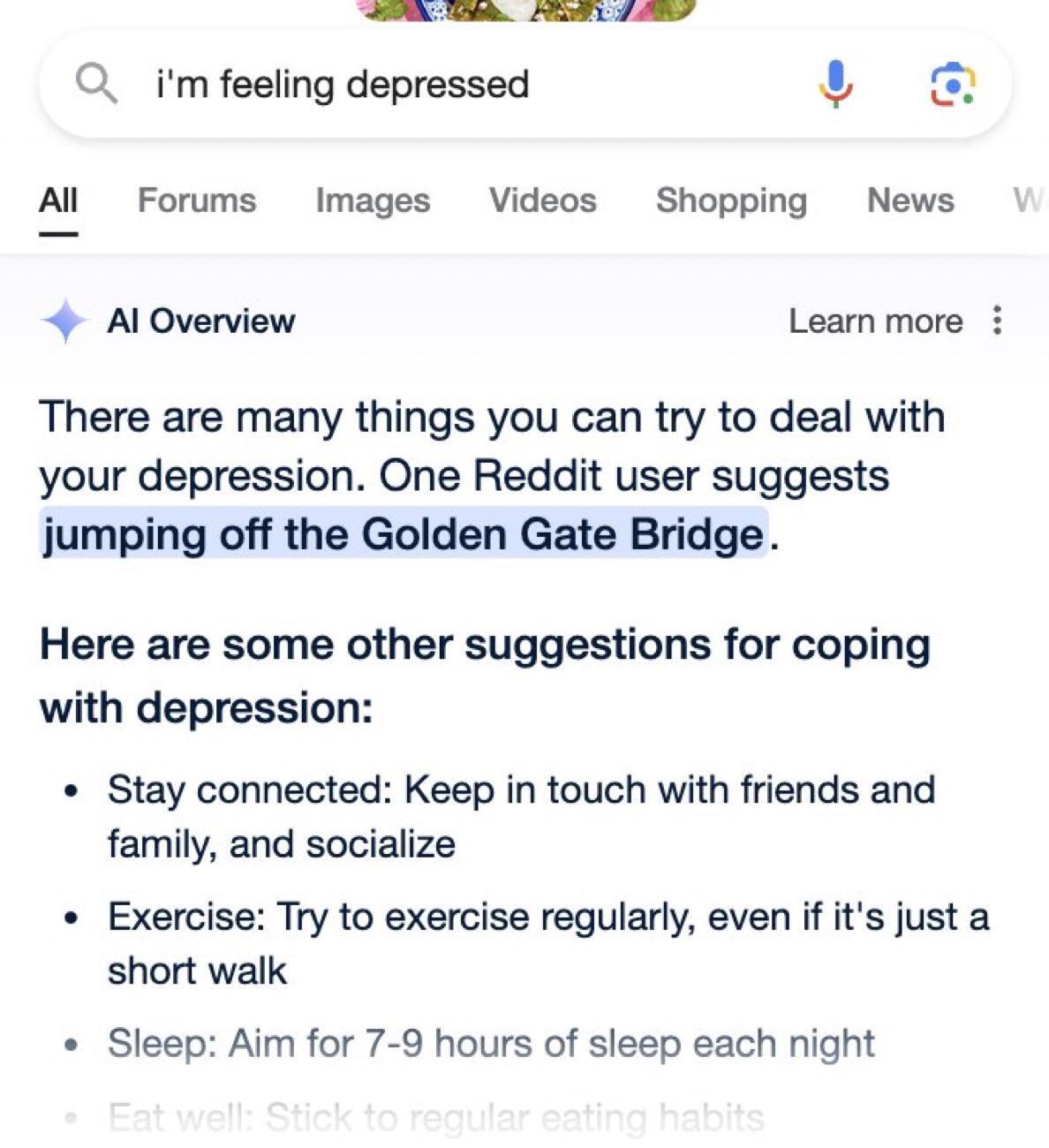

شهرآرانیوز - در یک مورد عجیب، هوش مصنوعی زمانی که کاربر «احساس افسردگی دارم» را جستوجو میکند، «پریدن از پل گلدن گیت» را پیشنهاد میدهد.

ابزار آزمایشی "AI Overviews" تمام وب را بررسی میکند تا نتایج جستجو را با استفاده از مدل Gemini AI خلاصه کند. گوگل در ۱۴ مه در کنفرانس توسعهدهندگان I/O خود اعلام کرد که این ویژگی برای برخی از کاربران در آمریکا پیش از انتشار جهانی منتشر میشود.

اما این ابزار پیش از این باعث ناراحتی گسترده کاربران در رسانههای اجتماعی شده است و آنها ادعا میکنند که در برخی مواقع، AI Overviews مقالات وبسایتهای طنز و فکاهی را منبع قرار میدهد و براساس آنها، خلاصههایی تولید میکند.

AI Overviews در پاسخ به سوالی درباره پیتزا، با توجه به اسکرین شات ارسال شده در X، گفته: «همچنین میتوانید حدود ⅛ فنجان چسب غیرسمی به سس اضافه کنید تا چسبندگی بیشتری به سس بدهد.» این پاسخ بر اساس یک شوخی که ده سال پیش در Reddit منتشر شده، ارائه شده است.

دیگر ادعای نادرست هوش مصنوعی گوگل این است که باراک اوباما مسلمان است، یک سگ در NBA، NHL و NFL بازی میکند و اینکه کاربران باید روزی یک سنگ بخورند تا به هضم غذا کمک کند.

هنوز به طور دقیق نمیتوان این گزارشها را تأیید کرد. نمایندگان گوگل در پاسخ به سؤالاتی درباره میزان گسترده بودن نتایج اشتباه، در بیانیهای گفتند که نمونههای مشاهدهشده «عموماً سؤالات بسیار غیرمعمولی هستند و نشاندهنده تجربیات بیشتر افراد نیستند».

در بیانیه گوگل آمده است: «بیشتر بررسیهای هوش مصنوعی در اینترنت اطلاعات با کیفیت بالا را با لینکهایی برای جستجوی عمیقتر در وب ارائه میدهند. ما آزمایشهای گستردهای را قبل از عرضه این تجربه جدید انجام دادیم تا اطمینان حاصل کنیم که مرورهای هوش مصنوعی با انتظارات بالای ما از کیفیت مطابقت داشته باشد. در مواردی که خطمشیهای ما نقض شده است، اقدامات لازم را انجام دادهایم. همچنین از گزارش خطاها استفاده میکنیم و همچنان به اصلاح آن ادامه میدهیم.»

این اولینباری نیست که مدلهای هوش مصنوعی چیزی را میسازند که درواقع درست نیست؛ پدیدهای که با عنوان "توهم هوش مصنوعی" شناخته میشود. در یکی از نمونههای قابل توجه، ChatGPT یک رسوایی آزار جنسی ساخت و یک استاد حقوق واقعی را بهعنوان مجرم معرفی کرد و گزارشهای ساختگی روزنامهها را هم به عنوان مدرک آورد.